Pourquoi certaines équipes d'ingénierie ont-elles du mal avec des déploiements lents, des versions imprévisibles et une gestion permanente des incidents, tandis que d'autres publient des logiciels de haute qualité de façon fluide et efficace ?

La différence ne réside pas seulement dans les compétences ; elle tient à la façon dont elles utilisent les données pour guider leurs décisions.

Une approche d’ingénierie pilotée par les données les aide à améliorer la qualité logicielle en suivant les indicateurs clés de performance, en analysant les tendances en temps réel et en exploitant des insights prédictifs.

Vous vous demandez comment les données peuvent optimiser vos processus d’ingénierie ? Ce guide explique les métriques utiles, les étapes concrètes à suivre et comment instaurer une culture pilotée par les données tout au long du SDLC.

Alors, commençons.

Qu’est-ce que l’ingénierie pilotée par les données ?

L’ingénierie pilotée par les données consiste à utiliser des métriques clés et des boucles de rétroaction continue pour obtenir des insights précieux. Cela vous aide à optimiser le développement logiciel même dans des systèmes complexes.

En pratique, les responsables techniques doivent prendre des décisions éclairées sur la base des données plutôt que de l’intuition, ce qui se traduit par :

- Une performance système améliorée

- Des taux d’échec réduits

- Un alignement avec les objectifs de l’organisation

Approches pilotées par les données vs approches traditionnelles

Il existe des différences fondamentales entre les approches traditionnelles et pilotées par les données, que nous détaillons ci-dessous :

1. Suivi de l’efficacité

Les équipes traditionnelles mesurent l’efficacité de façon anecdotique, ce qui rend difficile l’identification de ce qui fonctionne réellement. Imaginez un manager déclarant « On a l’impression d’aller plus vite ». Mais à quelle vitesse ?

L’ingénierie pilotée par les données élimine ce flou en vous permettant de surveiller des métriques comme DORA, Flow et SPACE metrics (par exemple le temps de revue de PR, les handofffs ou le coding time). Elles fournissent des données objectives sur la performance du flux de travail.

2. Détection des problèmes

Dans une configuration traditionnelle, les goulots d’étranglement n’apparaissent que lorsqu’ils deviennent critiques, comme un échec de déploiement de dernière minute ou une vague de rapports de bugs.

L’ingénierie pilotée par les données change la donne grâce aux analyses de décomposition du temps de cycle, au WIP, au throughput, aux analyses de PR, et plus encore, pour détecter les inefficacités avant qu’elles n’entravent la progression.

Nous vous recommandons la gestion de la chaîne de valeur pour éviter les goulots d’étranglement et fluidifier votre workflow.

3. Prise de décision

Les dirigeants peinent à justifier leurs choix dans des cultures d’ingénierie traditionnelles mal comprises, car il n’existe souvent aucune preuve tangible pour étayer leur raisonnement.

En revanche, l’approche pilotée par les données s’appuie sur des chiffres clairs qui facilitent la communication de la génération de valeur auprès de la direction.

4. Qualité du code

Dans les workflows classiques, la qualité du code n’est évaluée qu’après les échecs, généralement à la suite de plaintes clients ou de pannes. Cela freine l’innovation et augmente la dette technique.

Une démarche pilotée par les données permet de suivre en continu les métriques de qualité logicielle (taux d’échec des changements, fréquence des bugs, métriques de rework, etc.) pour repérer et corriger les défauts avant la mise en production.

5. Focalisation sur la performance

Les indicateurs traditionnels mesurent souvent la productivité individuelle, comme le nombre de lignes de code écrites ou le nombre de tâches accomplies.

Avec l’ingénierie pilotée par les données, on met l’accent sur la productivité de l’équipe et son efficacité globale. Plutôt que de récompenser uniquement la quantité, il s’agit d’optimiser continuellement la performance des systèmes et la santé de l’équipe.

Mais il faut aussi aligner vos efforts de développement sur les résultats business. La recherche montre que les organisations qui privilégient l’impact utilisateur affichent 40 % de performance organisationnelle en plus que les autres.

Et soyez également judicieux quant à vos outils : par exemple, l’utilisation d’un cloud public accroît la flexibilité de l’infrastructure de 22 %, ce qui se traduit par une augmentation de 30 % de la performance globale.

Suivre les métriques clés d’ingénierie est le meilleur moyen de dépasser la simple production individuelle et de générer une productivité durable tout en améliorant l’impact business global. Passons maintenant à la suite.

Pourquoi l’ingénierie pilotée par les données est essentielle

Découvrons pourquoi cette approche n’est pas seulement utile ; elle change la donne :

1. Vision stratégique et alignement des parties prenantes

Grâce aux KPI et aux modèles précis, vous gardez le cap sur les objectifs d'entreprise et les attentes des comités de direction. Au lieu de vous fier à l’intuition, vous pointez vers des données réelles.

Imaginez devoir moderniser votre infrastructure : plutôt que de la présenter comme une « amélioration nécessaire », vous utilisez un modèle prédictif pour démontrer son impact sur la performance et la fiabilité, et obtenir l’adhésion de la direction.

2. Meilleure prise de décision

L’ingénierie pilotée par les données vous permet de passer de l’instinct aux décisions fondées sur :

- Des méthodes scientifiques

- De la modélisation statistique

- Des techniques de machine learning

- L’IA pour la productivité des développeurs

Exemple : les code repositories accumulent parfois des inefficacités invisibles. L’analyse du churn (taux de réécriture), du review time et du temps de cycle révèle les points de friction : un churn élevé signale des exigences floues, un long review time indique des réviseurs surchargés, etc.

3. Résolution plus rapide des issues

Les goulots dans le processus de développement, la revue PR et les pipelines de déploiement ralentissent les projets. L’approche data-centric élimine ces blocages en mesurant des indicateurs d’efficacité opérationnelle tels que :

- DORA

- Analyses de temps de cycle

- Temps de revue de code

- Temps investi par type d’incident

- Work in Progress (WIP)

- Et plus encore

Ces insights vous permettent d’anticiper et de corriger les problèmes avant qu’ils n’impactent le taux d’échec.

4. Allocation optimisée des ressources

Sans données, il est courant de mobiliser temps, budget ou effectifs sur des tâches à faible impact. L’approche pilotée par les données met en évidence où concentrer vos efforts pour maximiser la valeur grâce à la répartition des ressources.

Par exemple, si l’analyse montre que vos ingénieurs passent trop de temps aux tests manuels, vous pouvez réaffecter ces ressources à des frameworks de tests automatisés, libérant ainsi votre équipe pour résoudre des problèmes plus complexes.

Vous pouvez également utiliser l’outil de Value Stream Mapping pour repérer les goulots et déterminer où l’automatisation – ou d’autres solutions – aura le plus d’impact.

5. Efficacité accrue des développeurs

Les développeurs s’épanouissent lorsqu’ils codent, pas lorsqu’ils sont coincés en réunions ou occupés avec des tâches répétitives sans valeur ajoutée. L’ingénierie pilotée par les données permet de dégager ces distractions en automatisant les tâches à faible impact.

Grâce au cloud et à l’IA, vos équipes passent moins de temps sur des opérations manuelles (analyse de logs, etc.) et plus de temps sur de véritables problèmes d’ingénierie.

Selon McKinsey, le développement logiciel comporte deux boucles principales :

- Boucle interne – Codage, compilation et tests unitaires (le travail créatif).

- Boucle externe – Intégration, tests, livraison et déploiement (nécessaire mais moins engageant).

Maximiser le temps passé dans la boucle interne augmente la productivité et la satisfaction, tandis qu’investir dans l’outillage et l’automatisation de la boucle externe libère du temps pour l’innovation.

Métriques d’ingénierie essentielles

Dans l’ingénierie pilotée par les données, certaines métriques font véritablement la différence, notamment :

1. Indicateurs avancés vs retardataires

Attendre qu’un incident se produise n’est pas une stratégie. Les approches traditionnelles s’appuient sur des indicateurs retardataires (rapports post-mortem) qui ne révèlent les problèmes qu’après coup.

À l’inverse, l’approche data-driven privilégie les indicateurs avancés, fournissant un feedback en temps réel pour prévenir les incidents. Parmi eux : le temps de cycle, la fréquence de déploiement et l’efficacité du flux : ils anticipent les goulots et les risques plutôt que d’analyser les échecs passés.

"Because leading indicators are a reliable (even if not so easy) way to check if the work done is actually generating impact to a startup’s goals. Without them we’d be in the dark about how meaningful people’s efforts (i.e., performance management) are. Also, we’d be lacking a valuable starting point for learning how to improve said efforts are over time."

2. Métriques axées sur la valeur

Des frameworks tels que DORA et Flow offrent de nombreuses métriques utiles pour l’ingénierie pilotée par les données, notamment :

Métriques DORA

Les métriques DORA (DevOps Research and Assessment) répondent à la question : « Notre processus de déploiement est-il efficace ou gérons-nous constamment des incidents ? » Elles comprennent :

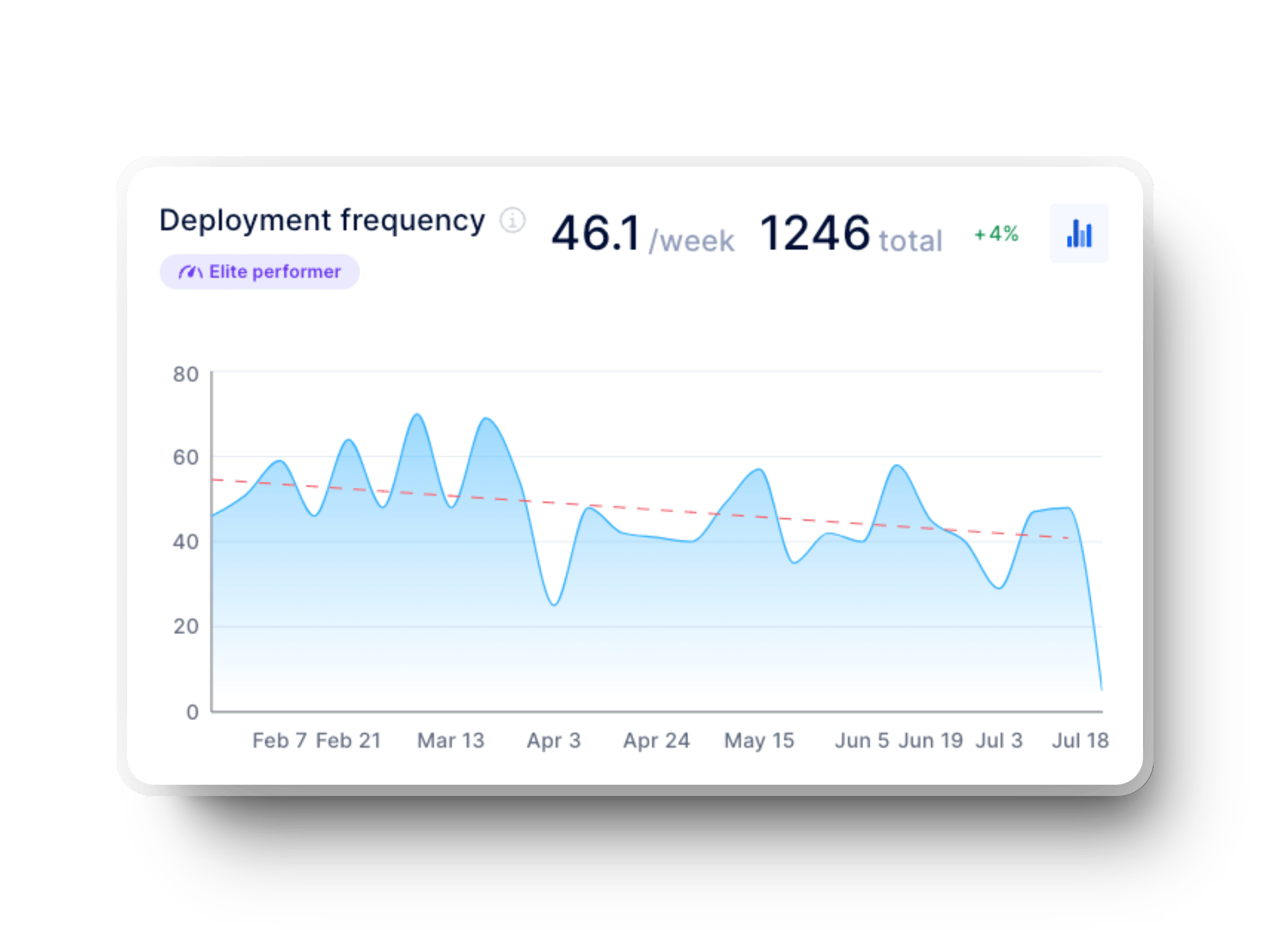

- Fréquence de déploiement : indique la fréquence à laquelle votre équipe publie du code en production. Plus c’est fréquent, mieux c’est ; des versions plus petites réduisent les risques et facilitent les retours en arrière.

- Délai nécessaire aux changements : mesure le temps nécessaire pour qu’un commit passe de la branche de développement à la production. Des délais longs signalent généralement des goulots dans les tests ou des pipelines CI/CD inefficaces.

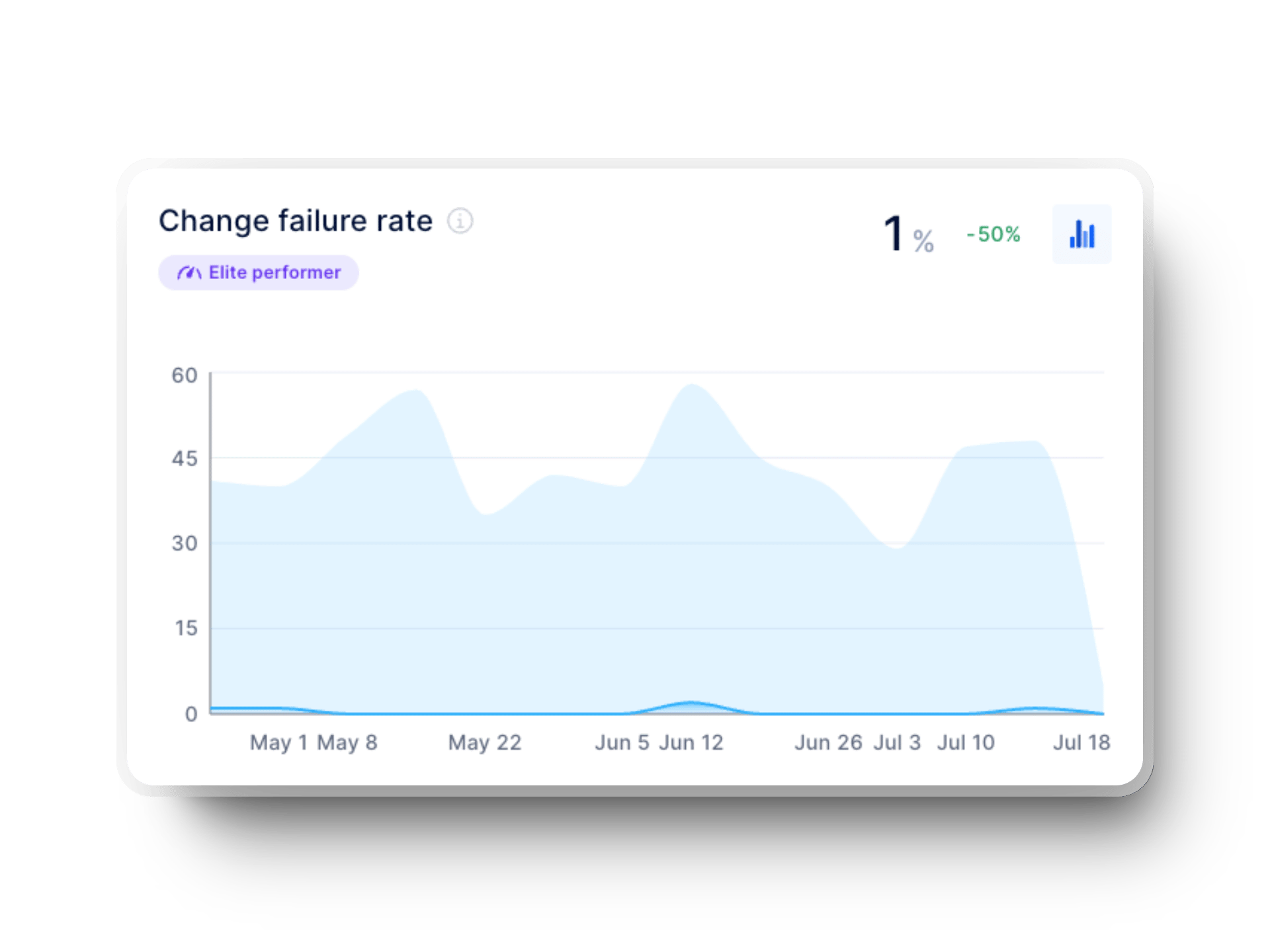

- Taux d’échec des changements : le pourcentage de changements causant des incidents. Un taux élevé indique qu’il faut renforcer la validation, améliorer la couverture de tests ou éviter les releases précipitées.

- Délai de récupération d'un échec: anciennement MTTR, cette métrique mesure la rapidité de votre réaction aux incidents. Un temps court témoigne d’une bonne capacité de réponse et d’un système résilient.

%20in%20axify%20for%20software%20development%20teams.webp?width=1920&height=1440&name=time%20to%20restore%20service%20(dora%20metrics)%20in%20axify%20for%20software%20development%20teams.webp)

Obtenez notre guide complet sur les métriques DORA

Métriques Flow

Les métriques Flow sont axées sur la valeur et indiquent la fluidité du travail dans le pipeline. En cas de lenteur de déploiement, elles aident à en déterminer la cause :

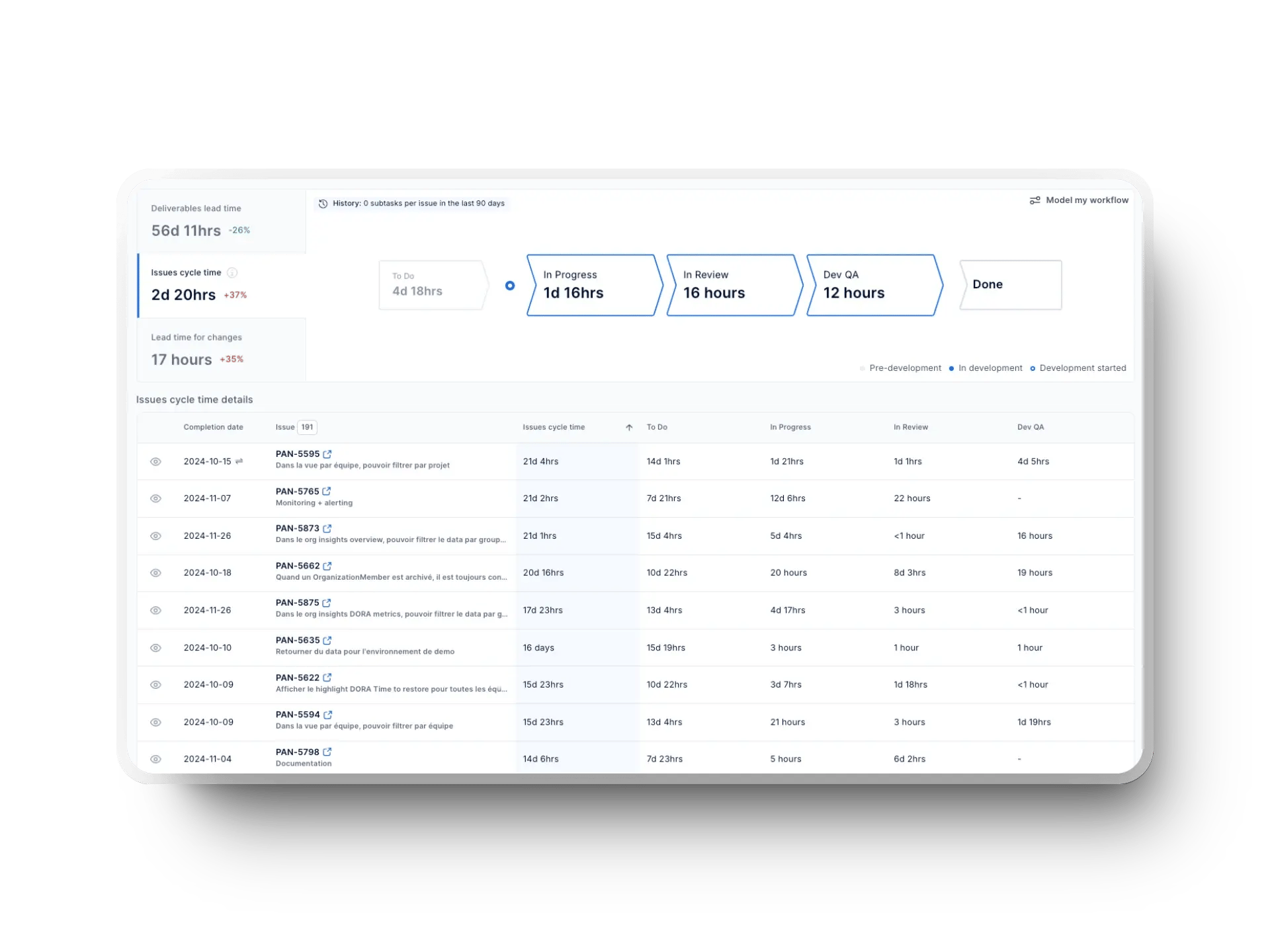

- Temps de cycle (Cycle time) : mesure la durée nécessaire pour achever une tâche depuis son lancement. Un temps de cycle plus court indique une équipe efficace, avec un développement rapide et peu de blocages.

- Débit (Throughput) : indique le nombre de fonctionnalités, corrections de bugs et mises à jour livrées sur une période donnée. Lorsque ces chiffres sont bas, il est temps d’agir sur les obstacles sous-jacents, comme un manque de ressources ou des priorités mal alignées.

- Travail en cours (WIP) : désigne les tâches ou fonctionnalités en cours mais pas encore terminées. Il est recommandé de ne pas accumuler trop de WIP afin d’éviter les changements de contexte et les retards. Règle simple : limitez-le à la taille de votre équipe plus ou moins un.

%20in%20Axify.webp?width=1920&height=1440&name=work%20in%20progress%20(WIP)%20in%20Axify.webp)

- Efficacité du flux (Flow efficiency) : compare le temps actif au temps total écoulé. Un score faible indique un temps d’inactivité excessif dû à des attentes d’approbation, des dépendances ou des priorités peu claires.

- Temps investi par type d’incident (Issue type investment): aide à déterminer où votre équipe consacre le plus de temps (nouvelles fonctionnalités, corrections de bugs, maintenance continue). Comprendre cet équilibre facilite la priorisation des tâches et réduit la dette technique.

Comment NE PAS utiliser les données en ingénierie pilotée par les données

Tout en explorant les métriques clés à suivre pour l’ingénierie pilotée par les données, il est tout aussi important de connaître les pièges à éviter, tels que :

1. Ne pas se concentrer sur le plus gros impact

Un des plus gros pièges de l’ingénierie pilotée par les données est de travailler sur des changements sans impact réel. Supposons que vos tests automatisés s’exécutent en 20 heures et que vous les réduisiez à 18 heures. Si votre processus de publication reste ralenti par un goulot de 46 jours dans la revue de code ou la mise à disposition d’infrastructure, ce gain de deux heures ne fera rien avancer.

En résumé, concentrez-vous sur les améliorations qui apportent un retour clair et accélèrent réellement votre cycle de livraison.

2. Ne pas aligner les métriques sur les objectifs business

Les métriques n’ont de valeur que lorsqu’elles sont reliées à vos objectifs. Sans cet alignement, vous risquez de poursuivre de mauvaises priorités. Par exemple, augmenter la fréquence de déploiement peut sembler un progrès, mais si ces versions ne sont pas stables ou n’améliorent pas la satisfaction client, elles n’ont pas de vraie valeur.

Cela signifie que chaque métrique suivie doit guider des actions directement alignées sur vos objectifs business, qu’il s’agisse d’améliorer la fiabilité ou l’expérience utilisateur.

Axify vous aide à suivre les objectifs pour mesurer les progrès de votre équipe par rapport aux objectifs d’entreprise.

![]()

3. Ignorer le contexte : ne pas considérer les métriques de façon holistique

Se focaliser sur une seule métrique conduit à de mauvaises décisions. Par exemple, si le temps de revue PR diminue, on se félicite d’un code plus rapide à déployer. Mais si la qualité en souffre, ces gains se paient par davantage de bugs et de régressions.

La solution ? Comme le recommande le framework SPACE, prenez du recul et combinez plusieurs métriques sur plusieurs dimensions. Ainsi, les progrès dans un domaine n’entraînent pas de régressions ailleurs. Dans cet exemple, vous pouvez également suivre le taux d’échec des changements et les incidents post-release.

4. Optimiser tout en même temps

Tout vouloir optimiser d’un coup ?

Suivre trop de KPI ralentit votre équipe. Vous passez votre temps à ajuster au lieu de livrer. Prenons l'exemple de la livraison de logiciels : la refonte du jour au lendemain peut sembler impressionnante, mais elle est virtuellement impossible. De petites améliorations constantes apportent plus de valeur qu’une refonte massive.

L’approche la plus intelligente consiste à se concentrer sur les métriques qui génèrent réellement de la valeur business et à laisser les autres de côté.

5. Utiliser les métriques pour évaluer les individus au lieu de l’équipe

Lorsqu’on juge les individus à partir de métriques de productivité (par exemple, le nombre de PR fusionnées par semaine), on instaure un climat de peur plutôt qu’une culture de croissance. Si les développeurs savent qu’on compte leurs lignes de code, ils risquent de produire un code gonflé pour atteindre l’objectif.

Il vaut mieux privilégier les tendances d’équipe et les métriques collaboratives, comme les métriques DORA, pour obtenir une vue d’ensemble de l’efficacité.

6. Se cacher derrière les métriques pour justifier une mauvaise gestion

Se fier uniquement aux données peut conduire à de mauvaises hypothèses. Un temps de cycle élevé peut sembler un signe de lenteur, alors que la cause réelle peut être des exigences floues ou des outils obsolètes.

La bonne méthode consiste à combiner le feedback qualitatif des ingénieurs avec des insights quantitatifs pour identifier les véritables goulots.

Comment faire des métriques un atout pour votre équipe

L’usage optimal des métriques d’ingénierie repose sur ces principes :

- Considérez les métriques comme des outils de feedback, pas comme des mesures disciplinaires

- Recherchez des tendances plutôt que de vous focaliser sur des valeurs isolées

- Priorisez les indicateurs à forte valeur et fournissant des recommandations actionnables

- Encouragez votre équipe à utiliser les données pour guider son amélioration, pas pour la juger

Ingénierie data-driven tout au long du SDLC

Cette approche alimente chaque étape du cycle de vie logiciel (SDLC) avec des données et transforme les insights en actions :

1. Planification et feuille de route

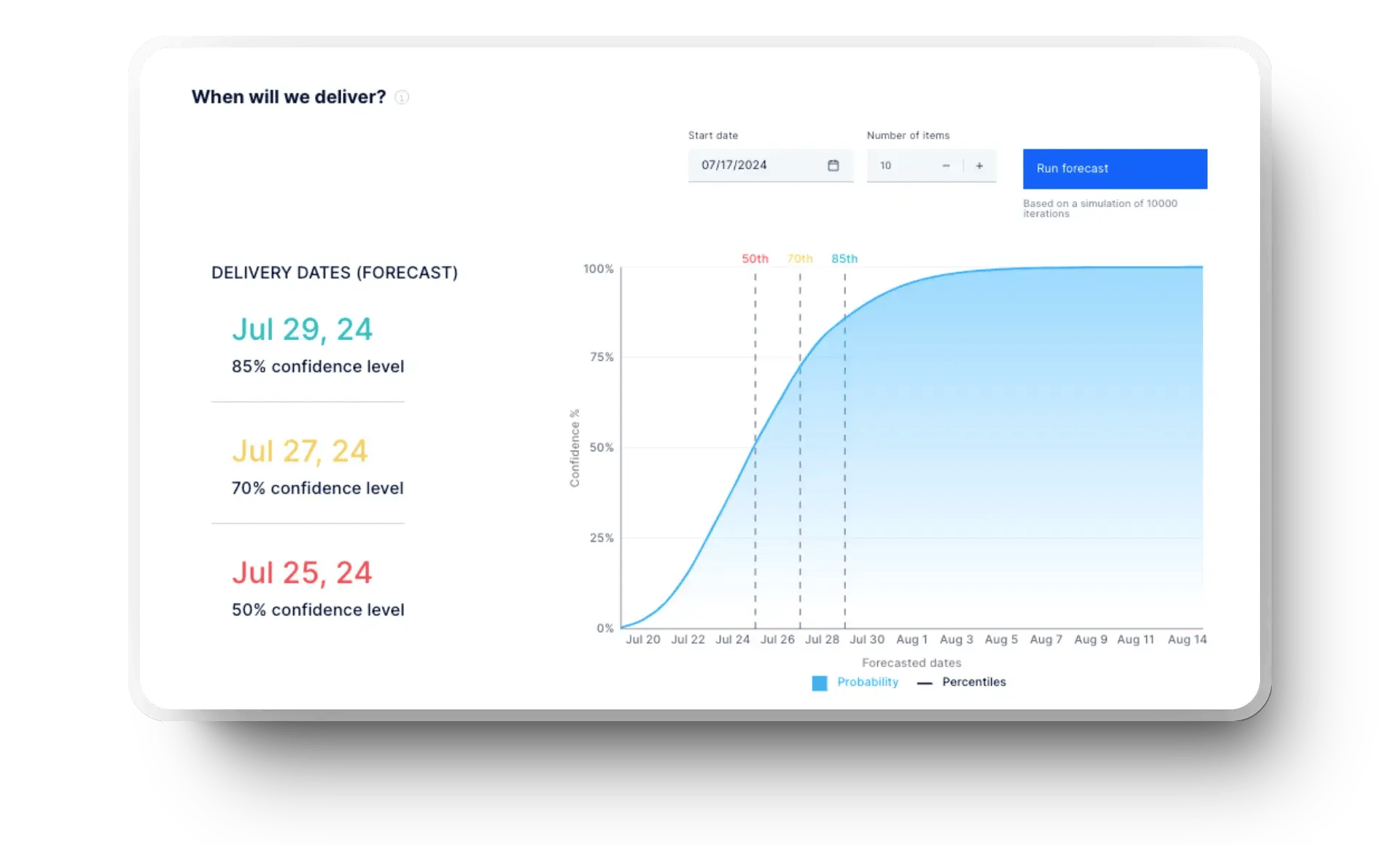

Les équipes qui se fient à l’intuition pour planifier les sprints ratent souvent les échéances et surchargent leurs ingénieurs. Servez-vous plutôt des données historiques de débit et des tendances du temps de cycle pour estimer la capacité de sprint sur la base de la performance réelle, non de cibles arbitraires.

Astuce : utilisez des outils comme la prévision de livraisons d’Axify, qui s’appuie sur les données pour analyser les tendances passées et prédire les dates de livraison.

Suivez également les tendances d’achèvement des tâches pour éviter les déséquilibres de charge. Lors de la planification, priorisez les retours clients et les données de défauts récurrents afin de livrer à temps, avec un impact maximal et en préservant le bien-être de l’équipe.

2. Développement

En phase de développement, réduisez les reworks en surveillant le taux d’échec des changements et les tendances de rework, ce qui aide à repérer tôt les fonctionnalités et stories à haut risque. Par exemple, si une fonctionnalité est sans cesse annulée, c’est le signe de tests manquants ou de dépendances instables – détectez-le tôt pour éviter les corrections de dernière minute.

L’ingénierie pilotée par les données permet aussi d’identifier les goulots d'étranglement dans le temps de cycle de revue des PR, améliorant ainsi la collaboration. En cas de blocages répétés, c’est souvent dû à des réviseurs surchargés, des retours peu clairs ou un processus trop lent. Corrigez ces failles pour obtenir des fusions plus rapides et moins de frustration pour tous.

3. Revue de code et fusion

Rien ne freine plus qu’un processus de revue de PR interminable. Lorsque les validations traînent, ce n’est pas seulement le code qui est en cause, mais aussi des retours flous ou des workflows inefficaces. Suivez les tendances de temps de revue pour identifier l’origine des retards et corrigez-les avant qu’ils n’impactent la productivité.

Concernant la fusion, si les PR stagnent, quelque chose cloche : stratégies de brancing complexes, validations manuelles ou manque d’automatisation. Mesurer les temps de fusion est un véritable atout pour fluidifier le processus et maintenir un flux de mises à jour constant sans sacrifier la qualité du code.

4. Déploiement et livraison

Déployer du code ne signifie pas simplement le publier ; il faut fournir des mises à jour stables et de haute qualité sans interruptions. La fréquence de déploiement est une métrique clé pour cela : elle permet de repérer les tendances dans le release cycle pour que les releases soient réguliers plutôt qu’imprévisibiles.

L’évaluation du lead time for changes est tout aussi essentielle. Cette métrique data-driven permet d’identifier rapidement les lenteurs dans les tests et les validations pour optimiser vos pipelines CI/CD. L’analyse du taux d’échec des changements révèle les points faibles dans les étapes de validation afin d’empêcher le code instable d’atteindre la production.

5. Surveillance et améliorations post-release

La collecte de données d’incidents en temps réel permet à vos équipes de détecter rapidement les problèmes et de réduire les temps de récupération après un déploiement raté. De plus, le suivi des bugs remontés par les clients et des régressions de performance post-release offre un aperçu précieux de l’expérience utilisateur, pour prioriser les corrections à fort impact.

Enfin, analyser les tendances des déploiements échoués dans le temps révèle des tendances. Avec ces informations, vous pouvez ajuster vos stratégies de release, renforcer les processus de validation et livrer des mises à jour toujours plus stables et qualitatives.

5 étapes pour instaurer une culture d’ingénierie data-driven

Envie de mettre en place une culture data-driven ? Suivez ces étapes claires :

- Expliquez la nécessité du changement : présentez des données historiques sur la fréquence de déploiement, les goulots et les inefficacités pour illustrer où ça bloque.

- Fixez des objectifs mesurables : privilégiez les résultats plutôt que les livrables, et laissez les frameworks DORA, Flow et SPACE guider vos mesures de performance, d’efficacité et de succès d’équipe.

- Choisissez les bonnes métriques : concentrez-vous sur les indicateurs avancés comme la fréquence de déploiement, le lead time for changes et le ratio de dette technique, qui révèlent les risques tôt pour fluidifier le workflow.

- Favorisez la transparence : plus besoin de fouiller dans les repositories pour trouver des insights. Un tableau de bord intégré et en temps réel offre aux ingénieurs et aux dirigeants une vue claire des métriques clés.

- Encouragez l’apprentissage : invitez votre équipe à explorer les données, repérer les tendances et expérimenter des solutions. Transformez chaque erreur en opportunité d’innovation.

Erreurs fréquentes en adoptant une démarche data-driven (et comment les éviter)

Adopter une approche pilotée par les données comporte des défis, mais voici des solutions pratiques pour les surmonter :

- Surcharge d’informations : suivre tout simultanément crée du bruit plutôt que de la clarté.

- Solution : priorisez les KPI actionnables présentés plus haut, car ils impactent directement la performance système et les décisions business.

- Résistance des équipes : certains perçoivent le suivi des données comme du micromanagement, ce qui bloque l’adoption.

- Solution : présentez les métriques comme des outils d’aide à la décision qui renforcent la performance collective, pas comme un contrôle absolu.

- Manque de maîtrise des données : les ingénieurs peuvent peiner à extraire des insights sans une bonne compréhension des KPI.

- Solution : formez vos équipes à la modélisation statistique pour interpréter efficacement les métriques de processus. Insistez sur les modèles prédictifs et les algorithmes d’optimisation.

- Outils éclatés et données dispersées : quand les dépôts de code et les systèmes sont déconnectés, obtenir une vue unifiée devient difficile.

- Solution : mettez en place des tableaux de bord intégrés comme Axify pour centraliser les données des repositories, des revues de code et des workflows. Vous obtenez une source unique de vérité pour adopter une approche véritablement data-centric.

Comment Axify aide les équipes d’ingénierie à devenir plus data-driven

Prêt à adopter une culture pilotée par les données dans votre workflow logiciel ? Axify propose plusieurs fonctionnalités clés :

- Insights en temps réel : centralise DORA et Flow dans un tableau de bord intuitif.

- Value Stream Mapping (VSM) : identifie les inefficacités tout au long du pipeline.

- Digest quotidien : met en avant les éléments à risque, structure les discussions de l’équipe et aide à planifier les tâches autour des vraies priorités.

- Prévision de livraisons : estime vos délais de livraison à partir de données historiques, pour toujours respecter vos échéances.

Faites des données votre allié. Commencez votre parcours avec Axify dès aujourd’hui en réservant une démo !

.webp?width=500&name=DORA%20e-book%20mockups%20(1).webp)

.webp?width=800&name=Axify%20blogue%20header%20(8).webp)